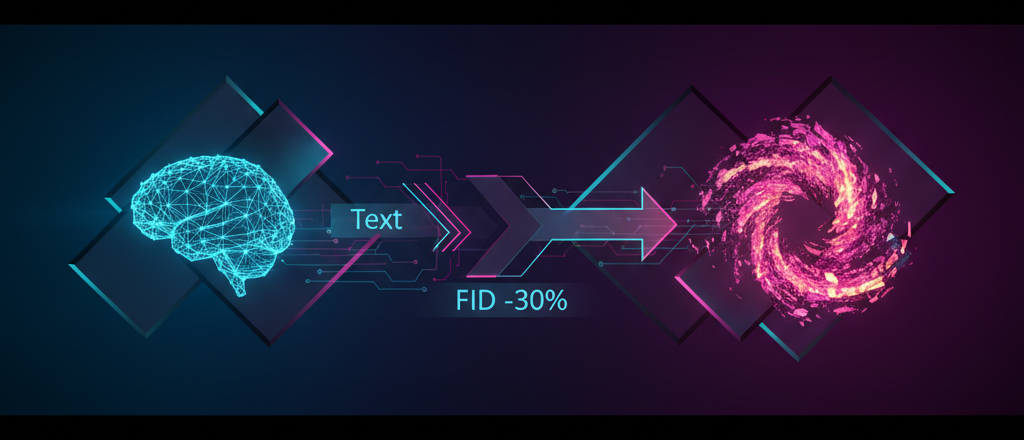

Core Line 3: 200K step secret, Muon optimizer, token routing

- REPA sort는 초기 가속기일 뿐이며 200K steps 이후에는 제거해야 함

- Muon optimizer 하나로 FID 18.2 → 15.55 달성 (15% 향상)

- 1024×1024 고해상도에서 TREAD token routing은 FID 14.10까지 감소

What happened?

Photoroom 팀이 text-to-image generation model PRX Part 2 최적화 가이드를 공개함. [Hugging Face] Part 1이 아키텍처에 대한 내용이었다면, 이번에는 실제 학습 시 무엇을 해야 하는지에 대한 구체적인 ablation 결과를 쏟아냈음.

솔직히 이런 종류의 기술 문서는 대부분 “우리 모델이 최고다”로 끝나지만, 이건 다름. 실패한 실험도 공개하고, 각 기술의 trade-off를 수치로 보여줌.

Why is it important?

text-image model을 처음부터 학습하는 데 드는 비용은 엄청남. 단 하나의 잘못된 설정으로도 수천 GPU 시간을 낭비할 수 있음. Photoroom에서 공개한 데이터는 이러한 시행착오를 줄여줌.

개인적으로 가장 주목할 만한 발견은 REPA (Representation Alignment)에 관한 것임. REPA-DINOv3를 사용하면 FID가 18.2에서 14.64로 떨어짐. 하지만 문제가 있음. throughput이 13% 감소하고, 200K steps 이후에는 학습이 실제로 저해됨. 간단히 말해서, 초기 부스터일 뿐임.

BF16 weight storage의 또 다른 버그. 이걸 모르고 FP32 대신 BF16으로 저장하면 FID가 18.2에서 21.87로 급증함. 3.67이나 올라감. 놀랍게도 많은 팀이 이 함정에 빠짐.

Practical Guide: Strategies by Resolution

| Technique | 256×256 FID | 1024×1024 FID | Throughput |

|---|---|---|---|

| Baseline | 18.20 | – | 3.95 b/s |

| REPA-E-VAE | 12.08 | – | 3.39 b/s |

| TREAD | 21.61 ↑ | 14.10 ↓ | 1.64 b/s |

| Muon Optimizer | 15.55 | – | – |

256×256에서는 TREAD가 실제로 품질을 저하시킴. 하지만 1024×1024에서는 완전히 다른 결과가 얻어짐. 해상도가 높을수록 token routing 효과가 더 큼.

What will happen in the future?

Photoroom은 Part 3에서 전체 학습 코드를 제공함. 이를 공개하고 24시간 “speed run”을 진행할 계획임. 좋은 모델을 얼마나 빨리 만들 수 있는지 보여주는 것이 목표임.

개인적으로 이 공개가 오픈 소스 이미지 생성 모델 생태계에 큰 영향을 미칠 것이라고 생각함. Stable Diffusion 이후 이렇게 자세하게 학습 노하우가 공개된 것은 처음임.

Frequently Asked Questions (FAQ)

Q: REPA는 언제 제거해야 하는가? One?

A: 약 200K steps 이후. 처음에는 학습을 가속화하지만, 그 이후에는 실제로 수렴을 방해함. 이는 Photoroom 실험에서 명확하게 밝혀짐. 시기를 놓치면 최종 모델의 품질이 저하됨.

Q: synthetic data 또는 real images 중 무엇을 사용해야 하는가?

A: 둘 다 사용. 처음에는 synthetic images를 사용하여 global structure를 학습하고, 후반 단계에서는 real images를 사용하여 high-frequency details를 캡처함. compositing만 사용하면 FID가 좋더라도 사진처럼 보이지 않음.

Q: Muon optimizer가 AdamW보다 얼마나 더 나은가?

A: FID 기준으로 약 15% 향상됨. 18.2에서 15.55로 떨어짐. computational cost가 비슷하므로 사용하지 않을 이유가 없음. 하지만 hyperparameter tuning이 약간 까다로움.

이 기사가 유용했다면 AI Digester를 구독해주길 바람.

References

- Training Design for Text-to-Image Models: Lessons from Ablations – Hugging Face (2026-02-03)